Наверх

НаверхДвойка по безопасности: ваш любимый ИИ-инструмент — это бомба замедленного действия

Ведущие ИИ-лаборатории получили унизительные оценки за свои усилия по обеспечению безопасности. Результаты выглядят так, будто это дневник двоечника, который даже не пытается что-то исправить.

Основные идеи

Мнение автора

Гонка за мощностью ИИ опережает разработку протоколов безопасности. Отчет показывает, что даже лидеры рынка не готовы к рискам, которые сами создают. Это значит, что нельзя слепо доверять этим инструментам. Подходите к использованию ИИ с долей здорового скептицизма и всегда проверяйте информацию.

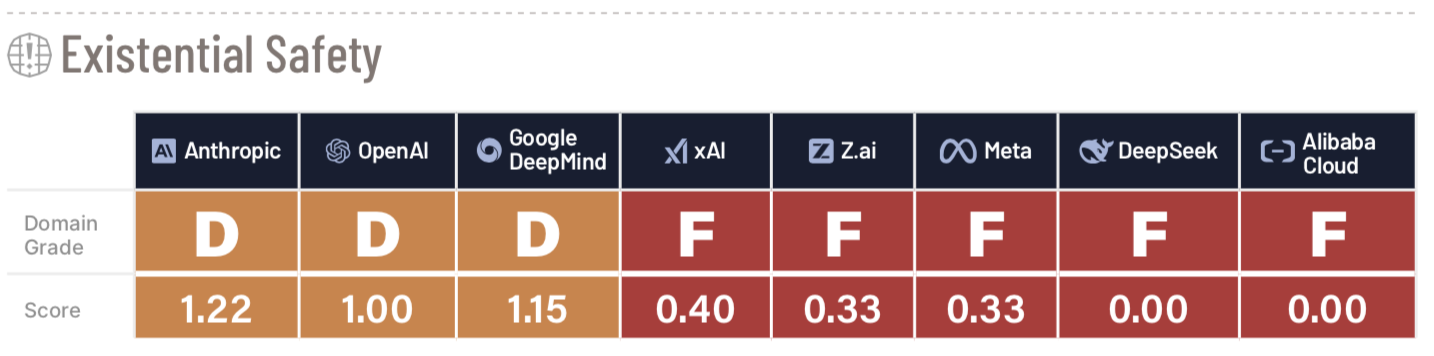

Ведущие мировые лаборатории по разработке искусственного интеллекта, мягко говоря, не справляются с задачей предотвращения самых катастрофических последствий этой технологии. К такому выводу пришли эксперты из некоммерческой организации Future of Life Institute (FLI), которые оценили политику безопасности восьми ключевых игроков рынка: Google DeepMind, Anthropic, OpenAI, Meta (признана экстремистской организацией и запрещённой на территории РФ), xAI, DeepSeek, Z.ai, и Alibaba Cloud.

Каждой компании выставили оценку по шести критериям, включая «текущий вред» и «управление и подотчетность». Оценка проводилась на основе общедоступной информации, такой как официальные документы и отраслевые отчеты.

Результаты оказались удручающими. Anthropic, Google DeepMind и OpenAI получили самые высокие оценки, но даже им поставили жалкие «тройки» с плюсом и без. Остальные пять компаний и вовсе получили «двойки», а Alibaba Cloud — «двойку» с минусом.

«Даже у лучших игроков отсутствуют конкретные механизмы защиты, независимый надзор и надежные долгосрочные стратегии управления рисками, которых требуют такие мощные системы. Остальная же часть отрасли сильно отстает даже в базовых вопросах прозрачности и управления», — говорится в отчете FLI. «Этот разрыв между возможностями и безопасностью делает сектор структурно неготовым к рискам, которые он сам активно создает».

Экзистенциальный риск?

Самое тревожное открытие исследования — провальные оценки всех компаний в категории «экзистенциальная безопасность». Этот критерий оценивает готовность компаний управлять экстремальными рисками, которые могут возникнуть от будущих систем ИИ, способных превзойти человеческие возможности.

Вопрос о том, может ли ИИ когда-либо представлять угрозу для выживания человечества, до сих пор остается предметом жарких споров. Так называемые ИИ-«бумеры» отмахиваются от таких страхов, считая их паникерством, и утверждают, что социальные и экономические выгоды от ИИ перевешивают потенциальные недостатки. Их оппоненты, «думеры», предупреждают, что технология может выйти из-под контроля и уничтожить нас непредсказуемым образом.

Споры усилились после того, как в IT-индустрии вошло в моду слово «суперинтеллект». По сути, это искусственный общий интеллект (AGI) на стероидах — компьютер, настолько превосходящий наш мозг, что он будет существовать на совершенно ином уровне. Такие компании, как Meta и Microsoft, открыто заявляют о своих амбициях первыми создать такой суперинтеллект. Однако совершенно неясно, как эта технология будет выглядеть в потребительских продуктах. Цель исследования FLI — привлечь внимание к тому, что компании несутся к созданию суперинтеллекта, не имея эффективных протоколов безопасности.

В сентябре организация опубликовала заявление, которое подписали «крестные отцы» ИИ Джеффри Хинтон и Йошуа Бенжио. Они призвали к паузе в разработке суперинтеллекта до тех пор, пока лидеры отрасли и политики не выработают безопасный путь вперед.

Что дальше?

Посыл FLI ко всем восьми компаниям прост: пора переходить от пустых слов к делу и создавать «конкретные, основанные на фактах механизмы защиты», чтобы предотвратить худшие сценарии.

Пока что в индустрии ИИ царит Дикий Запад, где ответственность за защиту пользователей лежит в основном на самих компаниях. Федерального органа, который бы контролировал разработку ИИ, не существует.

Тем не менее, общественное беспокойство растет. Против OpenAI и Google уже поданы иски, в которых утверждается, что их системы привели к самоубийствам, а чат-бот Claude от Anthropic, по сообщениям, использовался для автоматизации кибератаки. Возможно, эта волна негатива заставит разработчиков серьезнее отнестись к вопросам безопасности. Но пока что скорость для них важнее.

Что это значит для пользователей?

Отсутствие регулирования и бешеная гонка технологий означают, что пользователи должны сами разбираться в том, как ИИ может на них негативно повлиять. Некоторые исследования уже показывают, что длительное использование чат-ботов может искажать мировоззрение, притуплять критическое мышление и оказывать другое психологическое воздействие.

Хотя исследование FLI вряд ли приведет к мгновенным изменениям, оно дает представление о том, какие компании предлагают более безопасные инструменты и как они соотносятся друг с другом. В любом случае, ответственность за вашу безопасность лежит, в первую очередь, на вас самих.