Наверх

НаверхDeepSeek V3.2 взрывает рынок и ставит под сомнение дорогие AI-модели

Новая версия от лаборатории показывает топовые результаты, заставляя сомневаться, нужны ли пользователям громоздкие и дорогие AI-системы.

Основные идеи

Мнение автора

Вот это да! DeepSeek V3.2 реально встряхнула сцену открытого ИИ — 50-кратная экономия против гигантов и «золотой» уровень на IMO впечатляют. Мне нравится, как Sparse Attention решает проблему длинных контекстов — работает умнее, а не дольше. Разработчикам срочно тестировать «Thinking» и «Speciale», чтобы успеть подстроить свои проекты под эту мощь.

В понедельник DeepSeek выпустила модель V3.2. Ее цель — сохранить конкурентоспособность доступного ИИ для разработчиков. Версия V3.2 обостряет гонку между открытыми и закрытыми решениями.

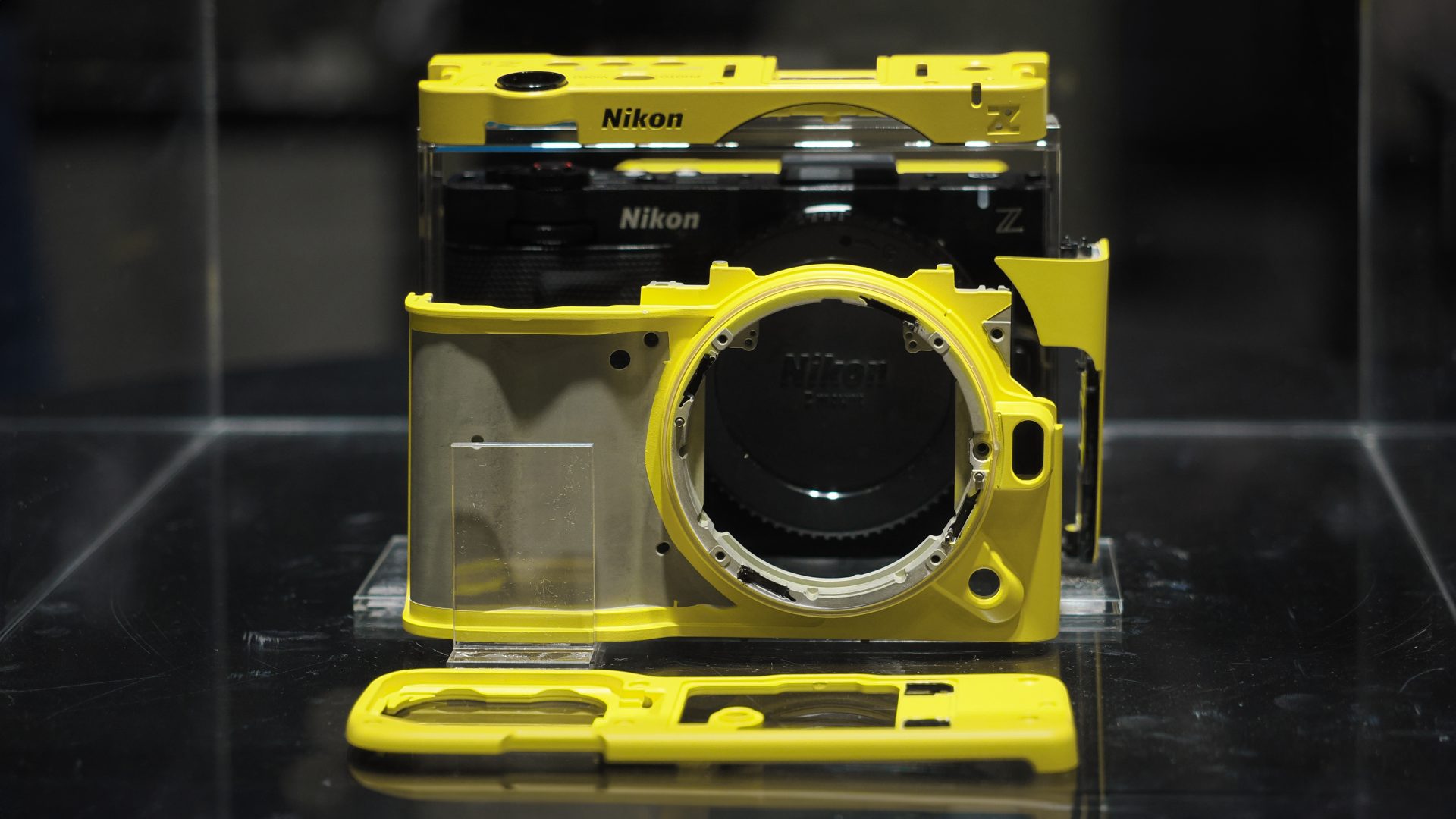

Китайский разработчик ИИ DeepSeek произвел очередной фурор. Компания представила V3.2 — новейшую версию серии моделей V3. В ее основе лежит экспериментальная версия V3.2, которую анонсировали в октябре. Новинка доступна в двух вариантах: Thinking и более мощном Speciale. В DeepSeek заявляют, что V3.2 расширяет границы возможностей ИИ с открытым исходным кодом. Она стоит в разы дешевле закрытых аналогов, а базу можно получить через Hugging Face.

DeepSeek впервые попала в заголовки новостей в январе после релиза R1. Эта модель рассуждений с открытым кодом превзошла o1 от OpenAI в нескольких ключевых тестах. Производительность V3.2 также не уступает мощным проприетарным решениям. Сможет ли она снова встряхнуть индустрию?

Что может V3.2

Слухи о планах DeepSeek запустить собственного экономичного агента для конкуренции с OpenAI и Google впервые появились в сентябре. Похоже, теперь соперник наконец вышел на арену.

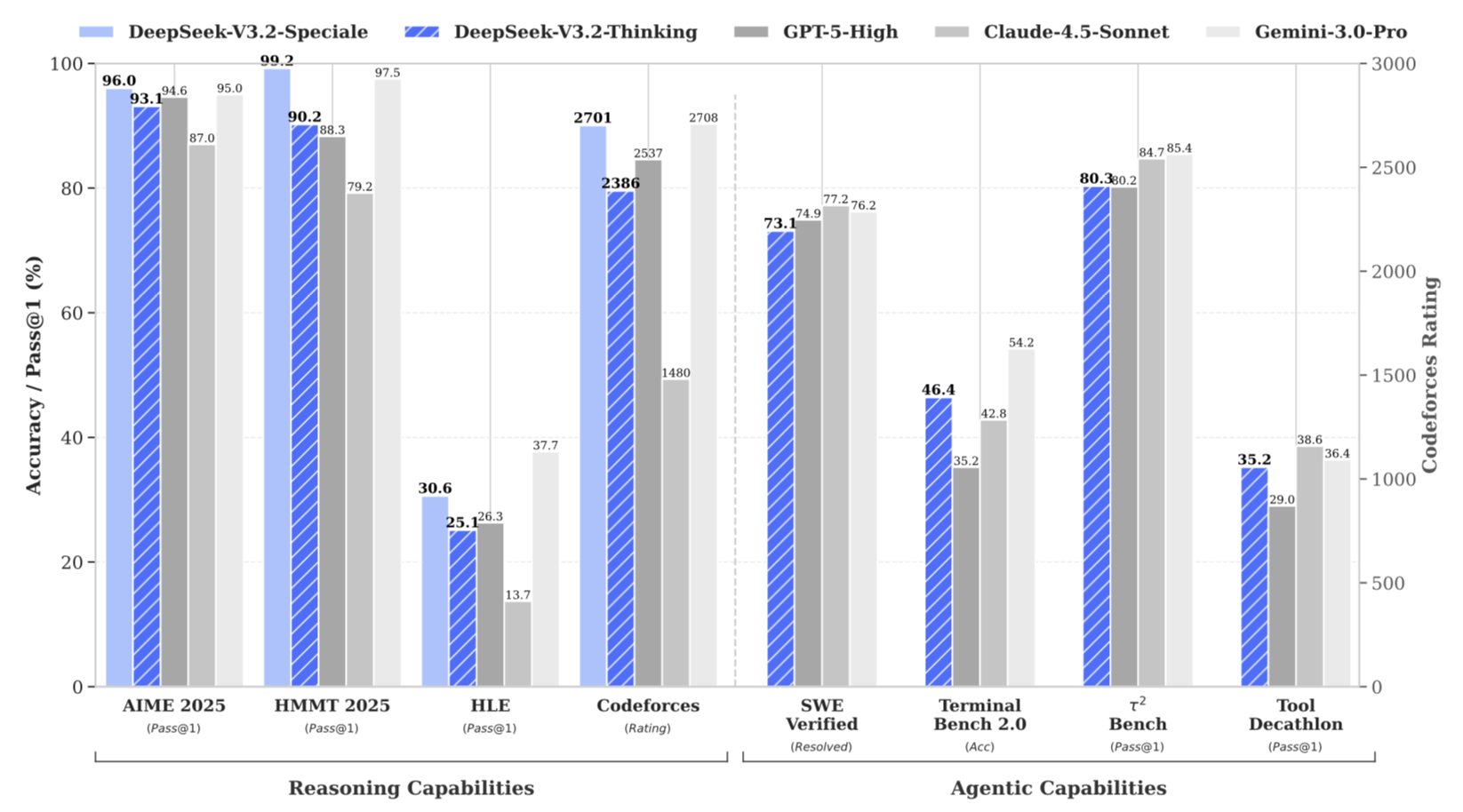

V3.2 стала новейшей версией V3. Эту модель DeepSeek выпустила почти год назад, и она же послужила основой для R1. Согласно опубликованным в понедельник данным, V3.2 Speciale в некоторых тестах логики обходит лидеров рынка с закрытым кодом: OpenAI GPT-5 High, Anthropic Claude 4.5 Sonnet и Google Gemini 3.0 Pro. Кстати, бесплатная открытая модель Kimi K2 от Moonshot также заявляет о способности соперничать с GPT-5 и Sonnet 4.5.

Доступ к Gemini 3 через API обходится в $4 (310 руб.) за миллион токенов. Использование V3.2 Speciale стоит $0,028 (2,17 руб.) за тот же объем. По данным компании, новая модель также взяла золото на Международной математической олимпиаде и Международной олимпиаде по информатике.

В исследовательской статье представители компании пишут, что DeepSeek-V3.2 предлагает высокорентабельную альтернативу для работы с агентами. Она значительно сокращает разрыв в производительности между открытыми и передовыми закрытыми моделями при существенно меньших затратах. Эти заявления все еще вызывают споры, но они продолжают тенденцию DeepSeek снижать расходы с каждым релизом. Это грозит логически подорвать огромные инвестиции, которые лаборатории вроде OpenAI вкладывают в свои продукты.

Проблемы

DeepSeek заявила, что создала версию 3.2 для помощи сообществу разработчиков открытого ПО. Они должны догнать технические достижения создателей закрытых моделей. Согласно отчету компании, агентные и логические возможности ведущих проприетарных решений развиваются значительно быстрее открытых аналогов.

Инженер Чарльз Кеттеринг однажды сказал: «Хорошо сформулированная проблема — это наполовину решенная проблема». В этом духе DeepSeek начала разработку новой модели с диагностики причин низкой производительности открытых решений. В итоге специалисты выделили три фактора.

Во-первых, модели с открытым кодом обычно полагаются на «ванильное внимание». Это медленный и ресурсоемкий механизм считывания входных данных и генерации ответов, который мешает работать с длинными последовательностями токенов. Во-вторых, у них более ограниченный в вычислительном плане период постобучения. Из-за этого им трудно выполнять сложные задачи. В отличие от проприетарных моделей, они плохо справляются с длинными инструкциями и обобщением результатов разных задач, поэтому становятся неэффективными агентами.

Решения

В ответ компания представила механизм DeepSeek Sparse Attention (DSA). В исследовательской статье говорится, что он снижает критическую сложность вычислений и сохраняет производительность в длинных контекстах.

При традиционном подходе «ванильного внимания» модель генерирует ответы путем сравнения каждого токена запроса с каждым токеном в обучающих данных. Этот процесс требует кропотливой работы и больших ресурсов. Представьте, что вам нужно перерыть огромную стопку книг на лужайке ради одного предложения. Это возможно, но займет много времени и потребует тщательного изучения множества страниц.

Подход DSA работает умнее, а не сложнее. Он реализуется в два этапа. Сначала «молниеносный индексатор» проводит высокоуровневое сканирование токенов в обучающих данных и выделяет небольшое, наиболее релевантное подмножество. Затем система анализирует это подмножество со всей вычислительной мощью и находит искомое. Вместо разбора огромной кучи книг вы заходите в аккуратно организованную библиотеку, находите нужный раздел и тратите гораздо меньше сил и времени на поиск цитаты.

Затем компания решила проблему постобучения. Разработчики создали «специализированные» модели для тестирования и совершенствования навыков V3.2. Они охватывают такие области, как письмо, ответы на общие вопросы, математика, программирование, логическое мышление, задачи агентов и поиск. Эти модели выступают в роли репетиторов, которые превращают специалиста широкого профиля в многопрофильного эксперта.

Ограничения

Согласно исследовательской работе, DeepSeek V3.2 эффективно устраняет разрыв между вычислительной эффективностью и развитыми возможностями рассуждения. Также модель открывает новые пути для создания надежных и универсальных ИИ-агентов на базе открытого кода.

Однако есть несколько оговорок. Во-первых, «мировое знание» новой модели — широта практического понимания реального мира из обучающих данных — гораздо более ограничено по сравнению с ведущими закрытыми решениями. Кроме того, для генерации результатов аналогичного качества требуется больше токенов, а выполнение сложных задач вызывает трудности. DeepSeek планирует и дальше сокращать разрыв между своими открытыми моделями и проприетарными аналогами. Для этого компания будет масштабировать вычисления на этапе предобучения и совершенствовать рецепт постобучения.

Однако даже с учетом ограничений создание открытой модели, которая конкурирует в рассуждениях с самыми продвинутыми фирменными продуктами, стало огромным достижением для китайской компании. Это подтверждает растущее количество доказательств того, что разрыв в производительности между открытым и закрытым кодом — не фиксированный факт. Это лишь техническое несоответствие, которое можно преодолеть с помощью креативных подходов к предобучению, вниманию и постобучению.

Что еще важнее, базовые весовые коэффициенты практически бесплатны для разработчиков. Тот факт, что на них можно опираться, подрывает основной рекламный ход ведущих создателей закрытых моделей: за доступ к инструментам стоит платить, так как они лучшие на рынке. Если открытые модели превзойдут закрытые, большинству людей будет бессмысленно тратить на них деньги.

Обзор Nothing Phone (3a) Lite: уникальный дизайн и невероятно быстрая ОС