Наверх

НаверхDeepSeek V3.2 снова бросает вызов дорогим ИИ-моделям

Китайская лаборатория показывает, что эффективный искусственный интеллект может обходиться без баснословных вложений.

Основные идеи

Мнение автора

DeepSeek V3.2 демонстрирует, что открытые модели могут реально конкурировать с проприетарными ИИ по возможностям рассуждения и задач. Компания удачно сочетает оптимизацию вычислений через Sparse Attention с усовершенствованным постобучением, снижая разрыв в производительности.

В понедельник DeepSeek выпустила свою модель V3.2. Ее цель — сохранить конкурентоспособность доступного ИИ для разработчиков. Версия V3.2 обостряет гонку между открытыми и проприетарными моделями.

Компания DeepSeek, которая занимается разработкой искусственного интеллекта, произвела очередной фурор и выпустила версию V3.2. Это новейшее обновление в серии моделей V3.

Модель вышла в понедельник и базируется на экспериментальной версии V3.2, которую анонсировали в октябре. Она доступна в двух вариантах: «Thinking» и более мощной «Speciale». В DeepSeek заявили, что V3.2 еще больше расширяет возможности ИИ с открытым исходным кодом. Она стоит в разы дешевле проприетарных аналогов, как и другие модели компании, а базовые веса можно получить через Hugging Face.

DeepSeek впервые попала в заголовки новостей в январе, когда выпустила R1. Эта модель рассуждений ИИ с открытым исходным кодом превзошла o1 от OpenAI в нескольких ключевых тестах. Производительность V3.2 также не уступает мощным закрытым моделям, поэтому это событие может снова встряхнуть индустрию ИИ.

Что может V3.2

Слухи о планах DeepSeek запустить собственный, более экономичный агент для конкуренции с OpenAI и Google появились еще в сентябре. Теперь конкурент наконец вышел на рынок.

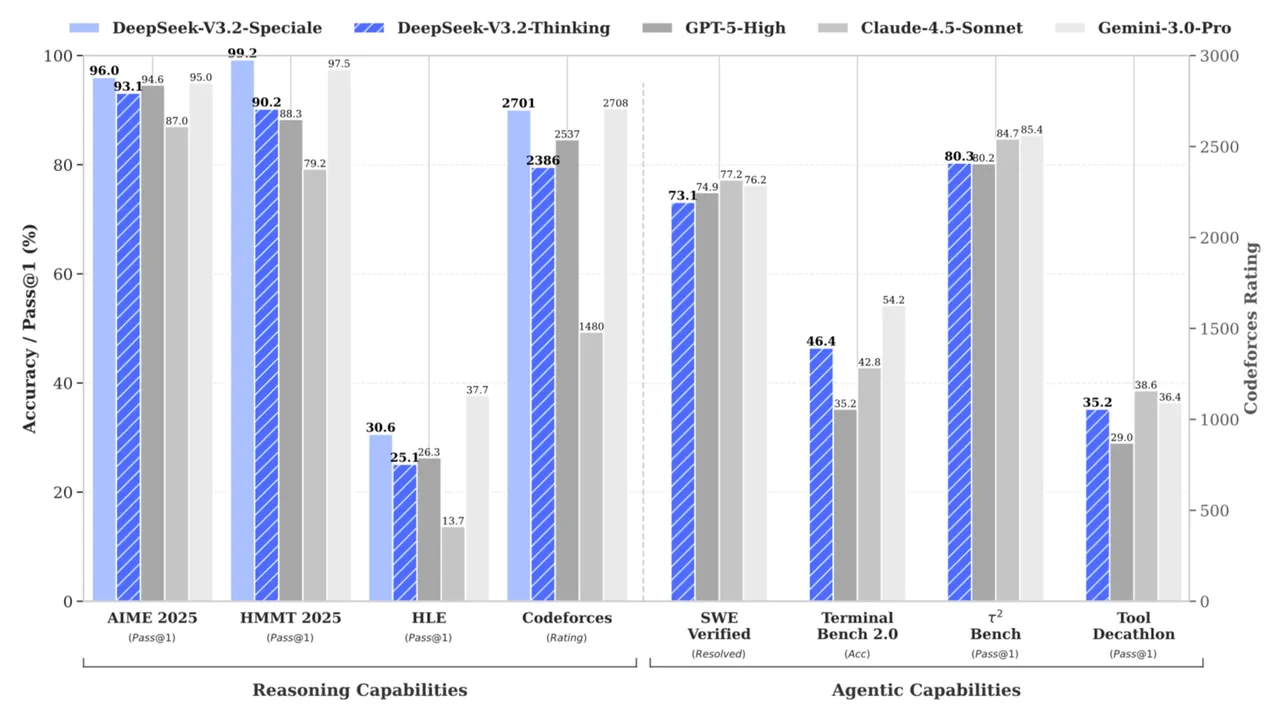

V3.2 представляет собой новейшую версию V3. Эту модель DeepSeek выпустила почти год назад, и она помогла в работе над R1. Компания в понедельник опубликовала данные, согласно которым V3.2 Speciale превосходит ведущие проприетарные модели в отрасли, такие как OpenAI GPT-5 High, Anthropic Claude 4.5 Sonnet и Google Gemini 3.0 Pro, в некоторых тестах логики. Кстати, Kimi K2, бесплатная модель с открытым исходным кодом от Moonshot, также заявляет о способности соперничать с GPT-5 и Sonnet 4.5 по производительности.

Что касается стоимости, доступ к Gemini 3 через API обойдется в 4 доллара (307,88 руб.) за миллион токенов, а к V3.2 Speciale — в 0,028 доллара (2,16 руб.) за миллион токенов. Компания сообщает, что новая модель также достигла «золотого» уровня на Международной математической олимпиаде и Международной олимпиаде по информатике.

DeepSeek-V3.2 представляет собой высокорентабельную альтернативу в сценариях с агентами. Она значительно сокращает разрыв в производительности между открытыми и передовыми проприетарными моделями при существенно меньших затратах. Об этом компания написала в своей исследовательской статье. Хотя эти заявления все еще вызывают споры, такое мнение продолжает тенденцию DeepSeek снижать затраты с каждым релизом. Это грозит логически подорвать огромные инвестиции, которые проприетарные лаборатории, вроде OpenAI, вкладывают в свои модели.

Проблемы

DeepSeek заявила, что создала версию 3.2, чтобы помочь сообществу разработчиков ИИ с открытым исходным кодом догнать некоторые технические достижения компаний с закрытым кодом. В отчете компании указано, что агентные и логические возможности ведущих проприетарных моделей развиваются значительно быстрее, чем у их открытых аналогов.

Инженер Чарльз Кеттеринг однажды сказал: «Хорошо сформулированная проблема — это наполовину решенная проблема». В этом духе DeepSeek начала разработку новой модели с попытки найти причины низкой производительности открытых систем и в итоге выделила три фактора.

Во-первых, модели с открытым исходным кодом обычно полагаются на так называемое «ванильное внимание». Исследователи ИИ называют так медленный и ресурсоемкий механизм считывания входных данных и генерации выходных, который затрудняет работу с длинными последовательностями токенов. Кроме того, у них более ограниченный в вычислительном плане период постобучения, что мешает выполнению сложных задач. В отличие от проприетарных моделей, им сложно выполнять длинные инструкции и обобщать результаты разных задач, поэтому они становятся неэффективными агентами.

Решения

В ответ компания представила механизм DeepSeek Sparse Attention (DSA). В исследовательской статье говорится, что он снижает критическую сложность вычислений и не жертвует производительностью в длинных контекстах.

При традиционном подходе «ванильного внимания» модель генерирует выходные данные и сравнивает каждый отдельный токен запроса с каждым токеном в обучающих данных. Это кропотливый и ресурсоемкий процесс. Представьте, что вам нужно перерыть огромную стопку книг, которые разбросали по лужайке, чтобы найти нужное предложение. Это возможно, но потребует много времени и тщательного изучения огромного количества страниц.

Подход DSA стремится работать умнее, а не сложнее. Он реализуется в два этапа. Сначала идет поиск с помощью «молниеносного индексатора», который выполняет высокоуровневое сканирование токенов в обучающих данных и выделяет небольшое подмножество, наиболее релевантное конкретному запросу. Затем система анализирует это подмножество и использует всю вычислительную мощь для поиска нужной информации. Вместо того чтобы начинать с огромной стопки книг, вы заходите в аккуратно организованную библиотеку, находите нужный раздел и тратите гораздо меньше сил и времени на поиск нужного отрывка.

Затем компания решила устранить проблему постобучения и создала «специализированные» модели. Они тестируют и совершенствуют навыки V3.2 в таких областях, как письмо, ответы на общие вопросы, математика, программирование, логическое мышление, агентные задачи, агентное кодирование и агентный поиск. Они работают словно репетиторы, задача которых — превратить модель из специалиста широкого профиля в многопрофильную.

Ограничения

В исследовательской работе указано, что DeepSeek V3.2 эффективно устраняет разрыв между вычислительной эффективностью и развитыми возможностями рассуждения. Также она открывает новые возможности для создания надежных и универсальных агентов ИИ с помощью открытого исходного кода.

Однако есть несколько оговорок. Во-первых, «мировое знание» новой модели гораздо более ограничено по сравнению с ведущими проприетарными моделями. Речь идет о широте практического понимания реального мира, которую можно получить из корпуса обучающих данных. Кроме того, для генерации результатов, которые соответствуют по качеству передовым закрытым моделям, требуется больше токенов, а выполнение сложных задач вызывает трудности. DeepSeek заявляет, что планирует и дальше сокращать разрыв между собственными моделями с открытым исходным кодом и проприетарными аналогами. Для этого компания масштабирует вычисления на этапе предобучения и совершенствует «рецепт постобучения».

Однако даже с учетом этих ограничений создание модели с открытым исходным кодом — огромное достижение. Тем более, что это сделала компания, которая способна конкурировать по возможностям рассуждения с самыми продвинутыми фирменными разработками на рынке. Это подтверждает, что «разрыв в производительности» между открытыми и закрытыми моделями не является фиксированным и неразрешимым фактом. Это техническое несоответствие, которое можно преодолеть с помощью креативных подходов к предобучению, концентрации внимания и постобучению.

Что еще важнее, базовые весовые коэффициенты практически бесплатны для разработчиков, которые могут на них опираться. Этот факт может подорвать основной рекламный ход ведущих создателей закрытых моделей. До сих пор они утверждали, что за доступ к этим инструментам стоит платить, поскольку они лучшие на рынке. Если открытые модели превзойдут закрытые, большинству людей будет бессмысленно платить за них.