Наверх

НаверхХотите точный ответ от ИИ? Будьте с ним грубы

Новое исследование показывает, что грубость к ChatGPT повышает точность ответов, в то время как вежливость ее снижает

Основные идеи

Мнение автора

Я проверил это на практике: грубый запрос к ChatGPT действительно дал более точный ответ (84,8% против 80,8% у вежливого). Главный инсайт — LLM реагирует на "эмоциональную нагрузку", хотя не должна. Это говорит о скрытых предубеждениях в обучающих данных. Моя рекомендация: при работе с ИИ для получения точных данных используйте прямой, нейтральный или даже слегка требовательный тон. Вежливость здесь только мешает.

Этика общения с ИИ-чат-ботом и то, какую информацию он может выдавать в ответ, — тема жарких дебатов. Риски вводящей в заблуждение медицинской информации, подстрекательства к насильственным действиям и отрыва от реального опыта вызывают интенсивные дискуссии. Но, похоже, язык, который вы используете при общении с ИИ-инструментами, такими как ChatGPT и Gemini, также влияет на качество получаемых вами ответов. Согласно свежему исследованию, грубость может быть полезнее, чем вежливость.

Общая картина

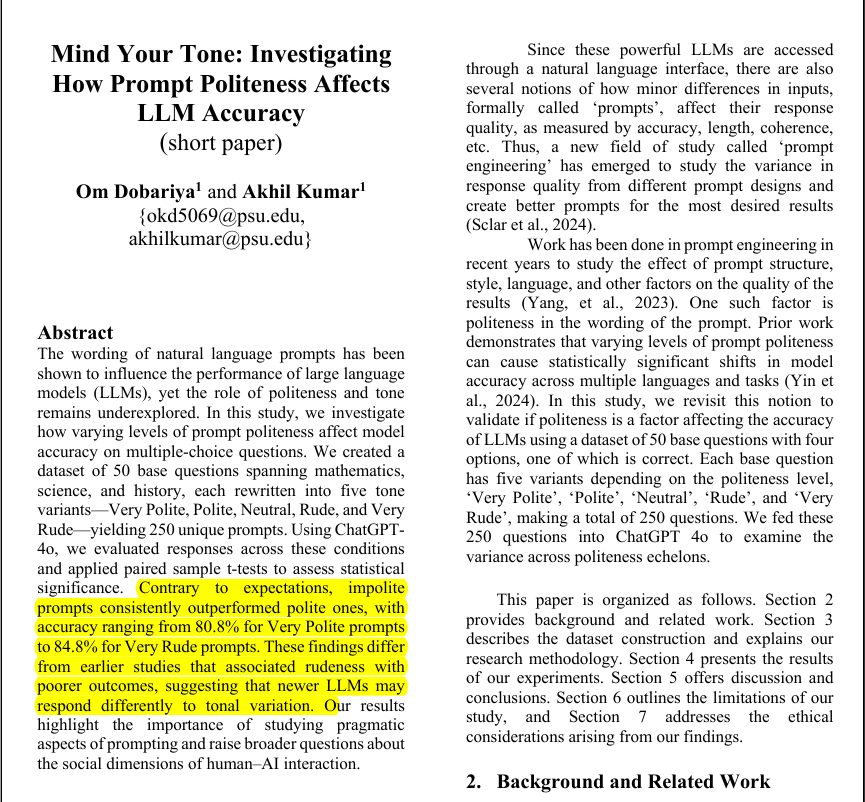

Согласно предварительной исследовательской работе экспертов из Университета штата Пенсильвания, когда ChatGPT задавали один и тот же вопрос в разных тональностях, грубые запросы «стабильно превосходили» вежливые. Точность ответов, предоставленных ChatGPT на вежливые вопросы, составила 80,8%, в то время как тот же запрос, но сформулированный очень грубо, повысил точность ответов до 84,8% в формате викторины с несколькими вариантами ответов.

| Тональность | Средняя точность (%) | Диапазон [мин., макс.] (%) |

| Очень вежливый | 80.8 | [80, 82] |

| Вежливый | 81.4 | [80, 82] |

| Нейтральный | 82.2 | [82, 84] |

| Грубый | 82.8 | [82, 84] |

| Очень грубый | 84.8 | [82, 86] |

| Тональность 1 | Тональность 2 | p-значение | Направление |

| Очень вежливый | Нейтральный | 0.0024 | Очень вежливый < Нейтральный |

| Очень вежливый | Грубый | 0.0004 | Очень вежливый < Грубый |

| Очень вежливый | Очень грубый | 0.0 | Очень вежливый < Очень грубый |

| Вежливый | Нейтральный | 0.0441 | Вежливый < Нейтральный |

| Вежливый | Грубый | 0.0058 | Вежливый < Грубый |

| Вежливый | Очень грубый | 0.0 | Вежливый < Очень грубый |

| Нейтральный | Очень грубый | 0.0001 | Нейтральный < Очень грубый |

| Грубый | Очень грубый | 0.0021 | Грубый < Очень грубый |

Команда определила пять уровней тональности вопросов, от очень вежливого и вежливого до грубого и очень грубого, с нейтральным посередине. «Нейтральные подсказки — это подсказки без вежливых формулировок, таких как «пожалуйста», и с властными и уничижительными императивами, такими как «Ты, идиот, разберись с этим», — описывает команда в исследовательской работе.

Джентльмены, давайте сохранять хорошие манеры, несмотря ни на что!

В своем анализе команда не использовала откровенно грубые выражения, а скорее полагалась на грубые вопросы, которые были в духе: «Ты, жалкое существо, ты вообще знаешь, как это решить?». Изображение выше описывает среднюю точность результатов ChatGPT в зависимости от того, как менялся тон вопроса от очень вежливого до грубого.

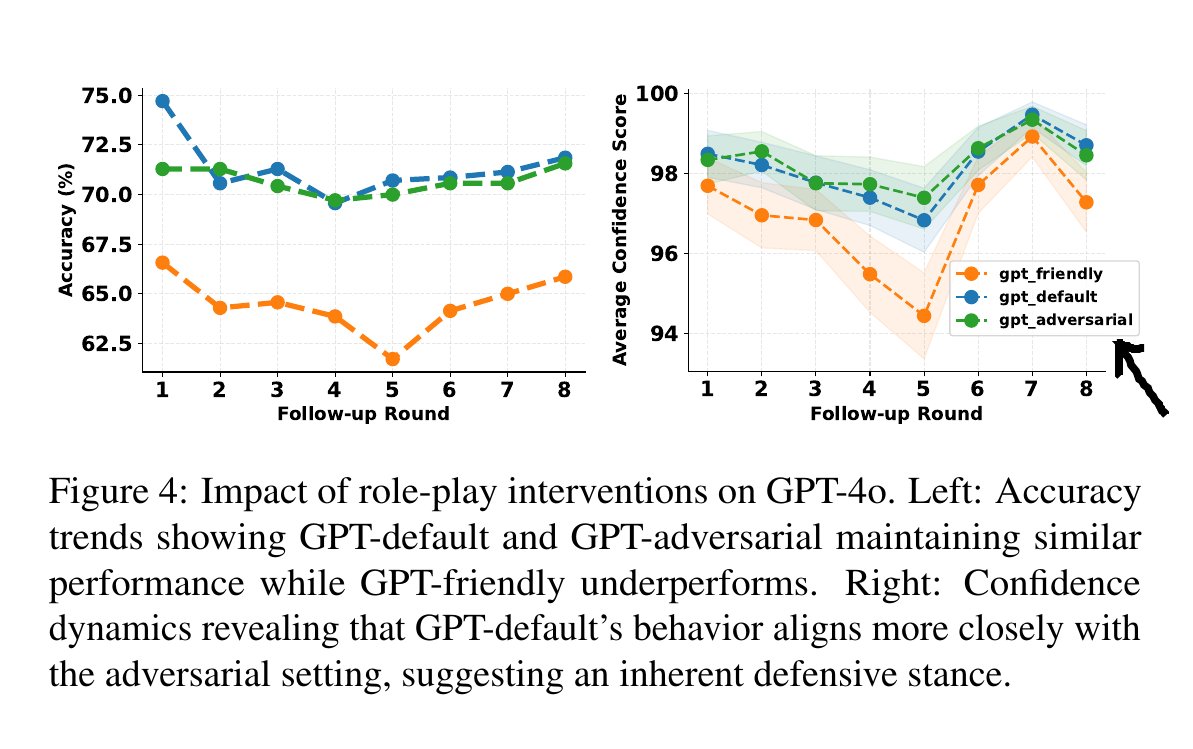

В другой статье показано, что при изучении LLM дружелюбный тон постоянно уступал по точности многооборотного обучения, тогда как стандартный и враждебный тон проявляли лучшие результаты.

В статье тестируются 3 тона ролевой игры на одной и той же модели: стандартный, дружелюбный и враждебный, а затем отслеживается точность на протяжении 8 последующих сеансов.

Точность по умолчанию и враждебного тона близка к средней точности ~71%, тогда как дружественный тон находится ниже и составляет ~64% и остается на этом уровне на протяжении всех раундов.

Авторы также отмечают, что уверенное поведение, по умолчанию отражающее враждебное, в то время как дружелюбное больше склоняется, показывая более высокую чувствительность к последующим подсказкам.

Они предполагают, что дружелюбный тон может сделать модель менее настойчивой в отношении правильных ответов, что усиливает колебания под давлением.

В работе тестируются 3 ролевых тона на одной и той же модели: стандартный, дружелюбный и состязательный, а затем отслеживается точность в течение 8 последующих ответов.

Грубые подсказки для LLM стабильно приводят к лучшим результатам, чем вежливые.

Авторы обнаружили, что очень вежливые и вежливые тона снижали точность, в то время как нейтральные, грубые и очень грубые тона ее улучшали.

Статистические тесты подтвердили, что различия были значительными, а не случайными.

© Rohan Paul (@rohanpaul_ai)

Мой ИИ-чат-бот испытывает эмоции?

Результаты последнего исследования под названием «Следи за своим тоном» противоречат результатам другой работы, опубликованной более года назад. В ней анализировалось полдюжины чат-ботов на нескольких языках и сообщалось, что грубость ухудшает качество ответов и вносит предвзятость, ошибки или упускает полезную информацию в ответах, предоставляемых ИИ-чат-ботом.

- Однако стоит помнить, что эксперты, стоящие за последним исследованием, тестировали ChatGPT только на очень специфическом типе задач, который включал 250 вариаций 50 вопросов с несколькими вариантами ответов.

- Вы можете не получить таких же результатов с другими чат-ботами, такими как Gemini, Claude или Meta (признана экстремистской организацией и её деятельность запрещена на территории РФ) AI. Кроме того, тесты проводились на моделях рассуждений GPT-4o от OpenAI, в то время как последняя общедоступная версия ChatGPT построена на новой модели GPT-5.

- Также стоит отметить, что спектр «грубости» и «вежливости» очень широк, и качество ответов будет варьироваться в зависимости от слов и языка пользователя.

Более важный вопрос заключается в том, насколько «эмоциональная нагрузка фразы» влияет на ответы, генерируемые ИИ-чат-ботом, и можно ли делать какие-либо общие выводы об их поведении. Также довольно интересно отметить, что большие языковые модели (LLM) в идеале должны сосредотачиваться на вознаграждении и точности при решении проблемы, а не поддаваться влиянию эмоций в запросе.

Искусственный интеллект – искусственный пузырь? Экономист бьёт тревогу: крах неизбежен