Наверх

НаверхDeepseek ломает правила: новый ИИ превращает текст в картинки, чтобы думать в 20 раз быстрее

Новая технология «сжатия текста в изображение» сокращает расходы на токены до 20 раз. Рассказываем, как это изменит будущее больших языковых моделей

Основные идеи

Мнение автора

Я считаю, что Deepseek нашла элегантное решение проблемы «длинного контекста». Сжатие текста в изображение — это не просто трюк. 10-кратное сокращение токенов при сохранении 97% точности — это реальный прорыв. Это напрямую снизит затраты на работу с большими документами в финансах и науке. Рекомендую внимательно следить за этой технологией. Она может изменить правила игры.

Разработчики из Deepseek AI выкатили новую модель, которая обещает перевернуть игру в обработке сложных документов и огромных кусков текста. Как сообщает SCMP, главная фишка в том, что нейросеть сначала превращает весь этот текстовый массив в картинки. Да-да, специальные визуальные кодеры берут гигантские объёмы текста и преобразуют их в изображения. Прикол в том, что для последующей работы с этими «картинками» требуется в 7-20 раз меньше токенов, а точность, говорят, остаётся на впечатляющем уровне.

Если кто забыл, Deepseek — это тот самый китайский ИИ, который наделал шуму в начале 2025 года, показав результаты, сравнимые с ChatGPT и Gemini, но при этом потребовав куда меньше денег и данных на разработку. С тех пор ребята не сидели сложа руки, и вот их новый релиз — DeepSeek-OCR. Эта штука умеет с поразительной точностью понимать гигантские объёмы текста, не сжирая при этом тонны токенов, как это обычно бывает.

«С помощью DeepSeek-OCR мы доказали, что сжатие текста в изображение может сократить количество токенов в 7-20 раз. Это открывает очень перспективное направление для работы с длинными контекстами», — хвастается один из разработчиков. Похоже, у нас намечается маленькая революция.

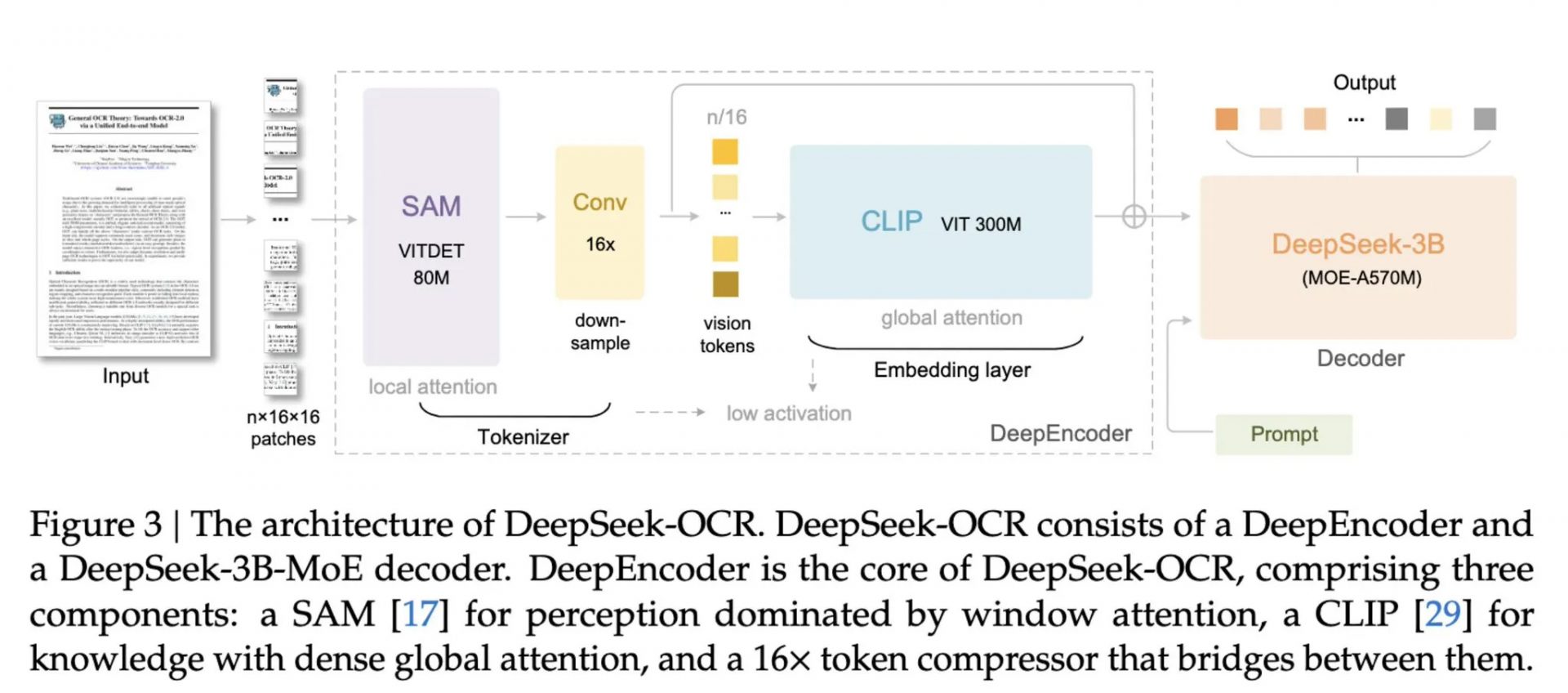

Новая модель состоит из двух компонентов: DeepEncoder и DeepSeek3B-MoE-A570M, который выступает в роли декодера. Энкодер может принимать большие объемы текстовых данных и преобразовывать их в изображения высокого разрешения. Декодер же особенно хорошо справляется с этими изображениями высокого разрешения и понимает текстовый контекст внутри них. При этом ему требуется меньше токенов, чем если бы вы просто подавали текст в ИИ напрямую. Он справляется с этим, разбивая каждую задачу на отдельные подсети и используя специальных ИИ-агентов для обработки каждого подмножества данных.

Это очень хорошо работает для обработки табличных данных, графиков и других визуальных представлений информации. По мнению разработчиков, это может быть особенно полезно в финансах, науке или медицине.

В ходе бенчмаркинга разработчики утверждают, что при сокращении количества токенов менее чем в 10 раз DeepSeek-OCR может поддерживать 97% точность при декодировании информации. Если степень сжатия увеличить в 20 раз, точность падает до 60%. Это менее желательно и показывает, что у этой технологии есть предел эффективности. Но если бы можно было достичь почти 100% точности даже при сжатии в 1-2 раза, это все равно могло бы значительно повлиять на стоимость запуска многих новейших ИИ-моделей.

Это также преподносится как способ разработки обучающих данных для будущих моделей, хотя внесение ошибок на этом этапе, даже в виде нескольких процентов отклонения от нормы, кажется плохой идеей.