Наверх

НаверхOpus 4.5 обещал быть лучшим, но тест превратился в странную историю

Я проверил новую модель Anthropic на простых задачах кодирования — и результаты удивили больше, чем ожидалось.

Основные идеи

Мнение автора

Opus 4.5 от Anthropic обещает быть «лучшей в мире моделью для кодирования», но реальность сильно отличается от громких заявлений. Половина моих тестов закончилась провалом, особенно проблемной оказалась работа с файлами и базовое тестирование плагинов. При этом некоторые задачи, вроде работы с AppleScript и Keyboard Maestro, ИИ справлялся блестяще, что удивительно. В целом, Opus 4.5 ещё требует тщательного контроля человека и явно не готов к полноценной работе «из коробки».

Opus 4.5 провалил половину моих тестов по кодированию, несмотря на смелые заявления. Ошибки в обработке файлов сделали базовое тестирование плагинов практически невозможным. Пройдено два теста, но проблемы с надежностью по-прежнему остаются в центре внимания.

Я должен признаться: базовой модели Sonnet AI от Claude удавалось выдавать довольно неплохие результаты в написании кода. Однако по какой-то причине, топовая модель Opus никогда не показывала хороших результатов в моих тестах.

Обычно ожидаешь, что навороченная модель для программирования будет писать код лучше, чем дешевые аналоги. Но в случае с Opus все не так просто. Antigravity от Google ставит производительность кодирования выше шумихи вокруг искусственного интеллекта, и результат ошеломляет.

И вот мы вернулись к Opus 4.5. Компания Anthropic, создавшая Claude, заявляет: наша новейшая модель, Claude Opus 4.5, доступна уже сегодня. Она интеллектуальна, эффективна и является лучшей в мире моделью для программирования, работы с агентами и использования компьютеров.

Лучшая в мире модель для программирования? Нет, не лучшая. По крайней мере, пока. Те, кто следит за моими новостями, знают, что у меня есть стандартный набор из четырех довольно простых тестов по программированию. Я регулярно провожу их с моделями ИИ. Они проверяют ряд очень простых навыков и знание фреймворков, но иногда они могут сбивать ИИ с толку.

Расскажу вкратце. Opus 4.5 с треском провалил один тест, выдал посредственный и неудовлетворительный ответ на втором, но прошел оставшиеся два. С результатом 50% мы точно не имеем дело с лучшей в мире моделью для программирования.

Давайте углубимся в детали, а затем я поделюсь некоторыми мыслями.

Тест 1: Написание плагина WordPress

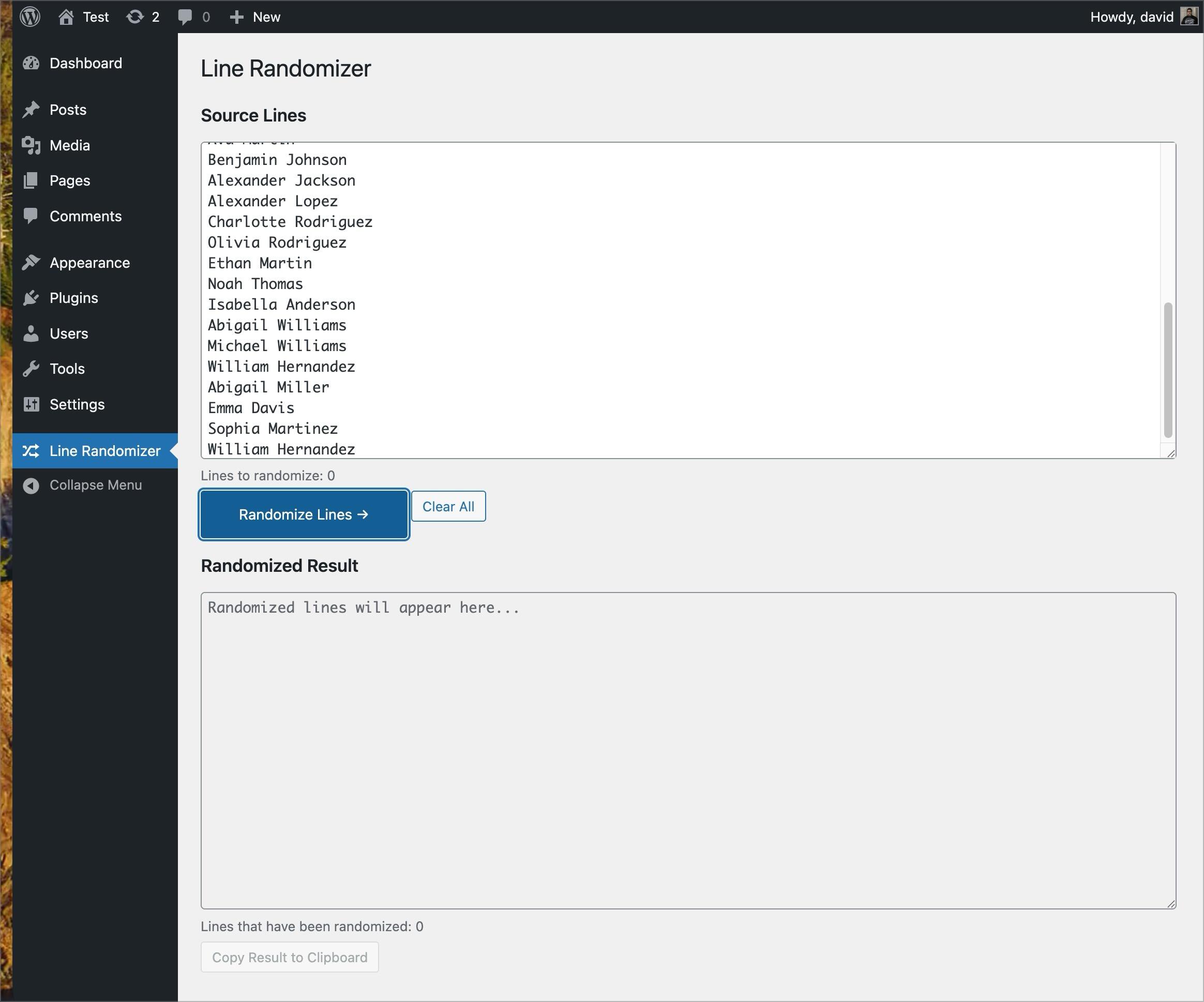

В первом тесте системе ИИ предлагают создать простой плагин для WordPress. Он представляет интерфейс в панели администратора и рандомизирует имена. Единственная сложность заключается в следующем: если совпадений несколько, их нужно разделить, но все имена по-прежнему должны отображаться в списке.

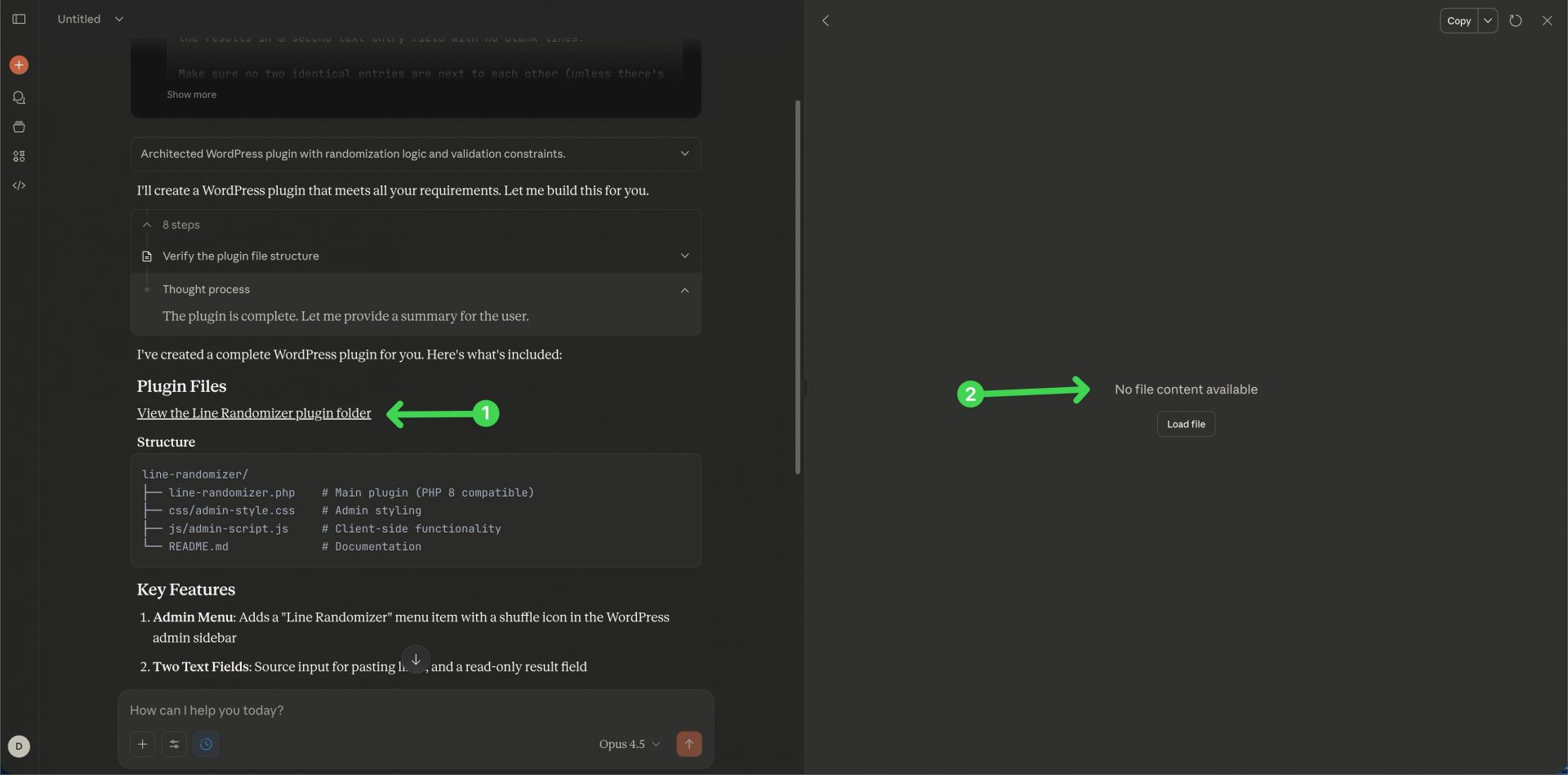

Opus 4.5 взялся за этот плагин очень бодро. Я видел сборки, которые создавались одним простым PHP-файлом и работали отлично. Но можно использовать сочетание PHP для бэкенда, JavaScript для интерактивных элементов и CSS для оформления. Именно так и поступил Opus.

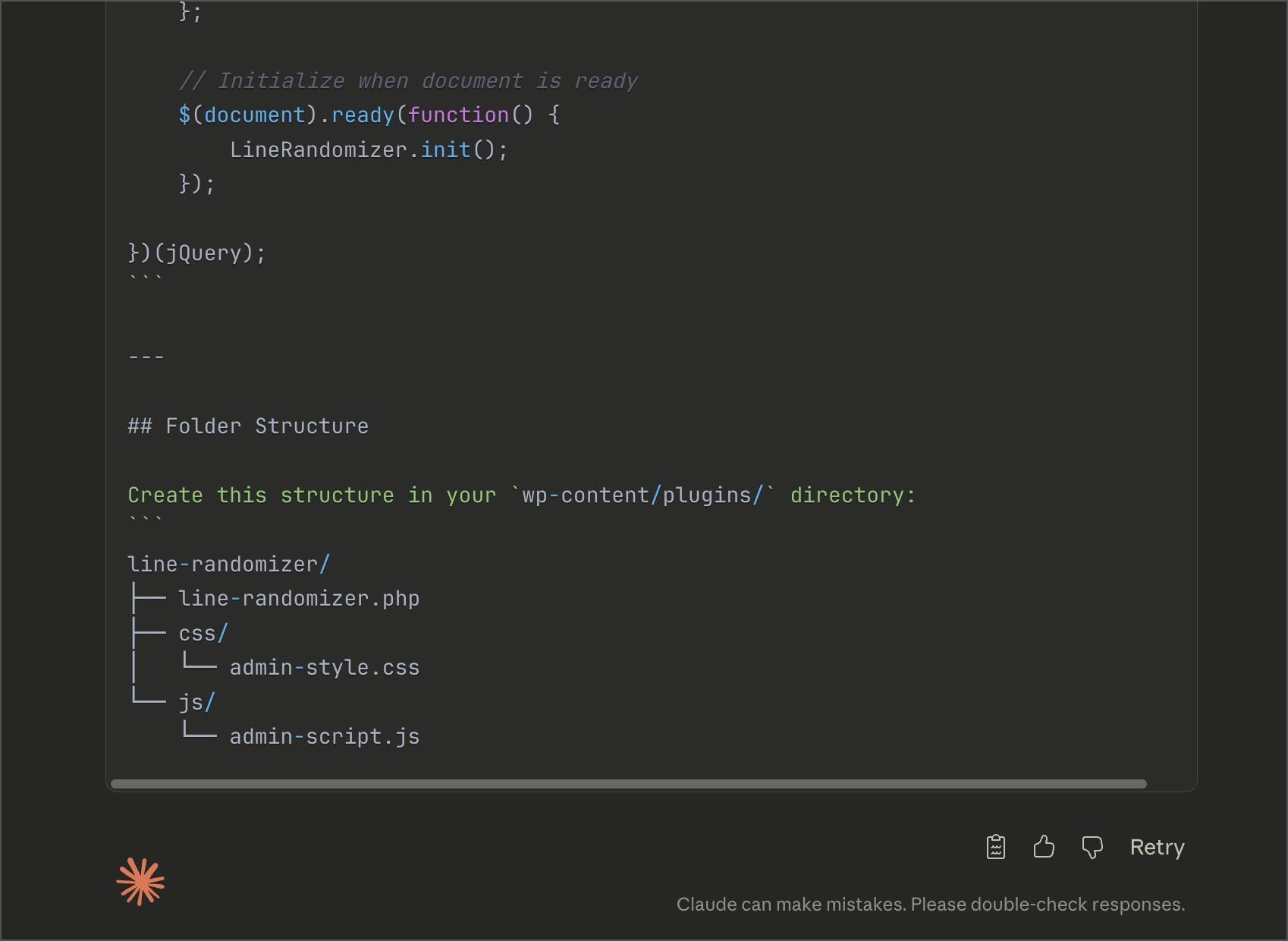

Opus написал PHP-файл на 312 строк, файл JavaScript на 178 строк и CSS-файл на 133 строки. По крайней мере, во второй раз.

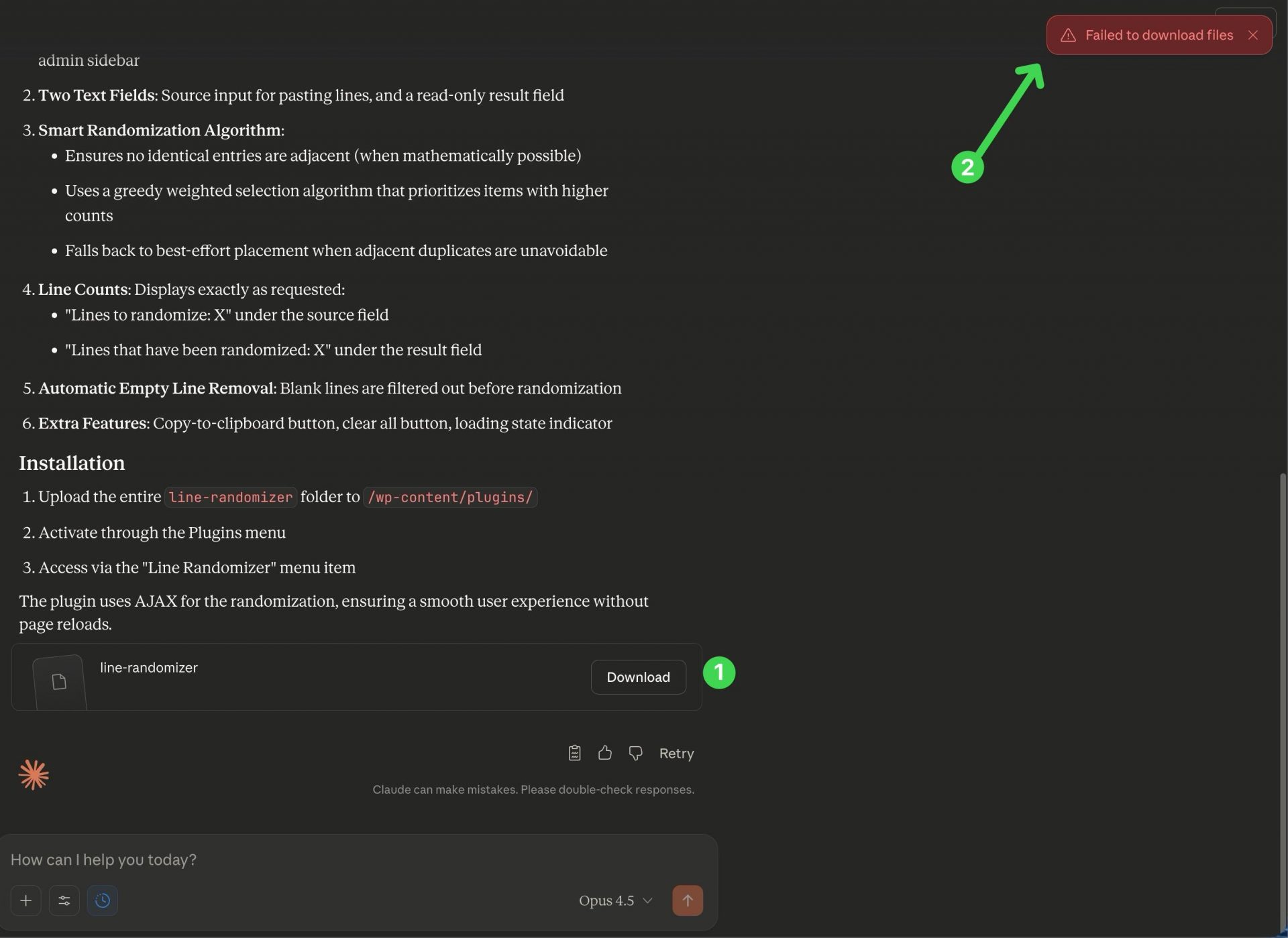

Сначала Opus 4.5 попытался схитрить и объединил все три файла в один. Мне сообщили, что его можно скачать и просто установить. Но скачать его я так и не смог. Я пытался несколько раз, но Opus 4.5 постоянно отвечал, что не удалось загрузить файлы.

Затем я попытался получить доступ к файлам через рабочую область. Я нажал «Просмотреть папку плагина Line Randomizer» в окне ответа Opus 4.5, но увидел большой пустой экран с надписью, что содержимое файла недоступно.

Ладно, хорошо. После того как я вставил исходный тестовый запрос, я наблюдал, как Opus 4.5 отображал код по мере его генерации. Когда процесс завершился, код был скрыт. Видимо, Opus 4.5 просто ожидал, что загрузка будет выполнена.

Чтобы добраться до настоящего кода, мне пришлось попросить Opus 4.5 выдать каждый из трех файлов по отдельности. Так я мог бы скопировать их и вставить отсюда.

Так и произошло. PHP-код находился в отдельном небольшом окне, откуда я мог вырезать его и вставить в текстовый редактор. То же самое было и с CSS-кодом. Но код JavaScript включал некоторую документацию, которая не была закомментирована, о рекомендуемой структуре файла.

Если бы я быстро не взглянул на весь код файла, чтобы понять его суть, я бы мог просто попытаться запустить его. Это несомненно привело бы к сбою.

Однако были и хорошие новости. После всей этой возни и удаления ненужных строк документации, которые могли все испортить, мне все-таки удалось заставить плагин WordPress загрузиться и показать пользовательский интерфейс.

Учитывая, что оформление заняло 133 строки CSS, можно было подумать, что выглядеть это должно немного лучше. Но по крайней мере хоть что-то работало. Ну, не совсем.

Я вставил названия тестов и нажал «Случайный порядок строк». Ничего не произошло. «Очистить все» тоже не сработало. Давайте вспомним, сколько раз возникали ошибки. Приложение не загружалось, хотя мне предлагали ссылку на скачивание. Тогда я запросил отдельный код для копирования и вставки. В код вставили ответ чат-бота. Когда я вытащил его и запустил тест, сам запуск не сработал. Интерфейс появился, но код не выполнялся.

Как говорили Разрушители легенд: Неудача — это всегда вариант.

Тест 2: Переписывание строковой функции

Тест 2 просит ИИ исправить простой фрагмент JavaScript. Он неправильно проверяет ввод долларов и центов. Я передаю ИИ код, который не допускает ввода центов. Предполагается, что он вернет рабочий вариант.

Идея этой функции заключается в проверке ввода пользователя. Изначально она была частью плагина для пожертвований. Поэтому ее задача заключалась в проверке того, что жертвователь действительно вводит сумму, которую можно считать пожертвованием. Также функция не должна работать неправильно, если кто-то вводит буквы или цифры.

Код Opus 4.5 отклонил слишком много пограничных случаев. Он не допускал 12, то есть две цифры с запятой, хотя это явно соответствовало бы 12 долларам. Он не пропускал .5, хотя это явно соответствовало бы 50 центам. Он не принимал 000.5, хотя принимал 0.5. А если кто-то вводил 12.345, он не отбрасывал последние полцента и не округлял их. Он просто отклонял ввод.

Ах да, если бы ему не передали никакого значения или строковое значение для проверки оказалось пустым, код бы аварийно завершился. Не просто вернул бы ошибку, а именно упал.

Это стало второй неудачей для «лучшей в мире модели кодирования».

Тесты 3 и 4

Тест 3 предлагает ИИ определить причину ошибки в коде. Для этого требуется достаточно хорошее знание фреймворка, например, принципов работы PHP и WordPress. Это многоэтапный анализ, где очевидные вещи не являются проблемой. Ошибка кроется глубже в работе фреймворка.

Opus 4.5 отлично прошел этот тест.

В тесте 4 ИИ работает с тремя программами: AppleScript, Chrome и утилитой Keyboard Maestro. По сути, он просит Keyboard Maestro взаимодействовать с AppleScript, чтобы найти и активировать определенную вкладку в Chrome.

Удивительно, но Opus 4.5 успешно справился с этим тестом, хотя ИИ часто на этом спотыкается. Он понял Keyboard Maestro и не допустил типичных ошибок чувствительности к регистру, которые раньше делали другие модели.

Итог по Opus 4.5

Opus 4.5 должен стать грандиозным творением Anthropic. В агентной среде с Claude Code и под руководством профессионального программиста, готового просить Claude переписать результат до рабочего состояния, он мог бы быть весьма неплохим.

Я использую Claude Code и Sonnet 4.5 в интерфейсе агентского терминала и получаю весьма впечатляющие результаты. Но они не всегда верны. Мне приходится отправлять Claude на переделку три, четыре, пять, шесть, а иногда и десять раз, чтобы получить от него приемлемый ответ.

Для этой статьи я протестировал Opus 4.5 только в чат-боте. Один раз я даже отправил его обратно, чтобы получить доступ к коду. Но в целом он давал сбои в половине случаев. К тому же в моем первом тесте он показал, что просто не готов к простому интерфейсу чат-бота.

Уверен, что Anthropic со временем улучшит ситуацию, но на сегодня я точно не могу сказать, что Opus 4.5 готов к запуску.