Наверх

Наверх2026: год, когда слепое доверие ИИ станет дороже, чем его внедрение

Хватит выбирать между «быстро» и «безопасно». Есть восемь принципов, которые ломают этот шаблон. Это не теория — это инструкция по сборке конкурентного преимущества, где скорость разработки ИИ растет именно за счет встроенной надежности.

Основные идеи

Мнение автора

Главный инсайт - просто начните тестировать всё в изоляции, поставив четкие правила. Ну, например, «никакого корпоративного бренда вовне». Вот так, друзья, вы сможете сочетать быстрые эксперименты и при этом не натворить дел. Сначала докажите, что ваша штука безопасна на каких-нибудь внутренних процессов, а уж потом вкладывайте деньги в масштабирование.

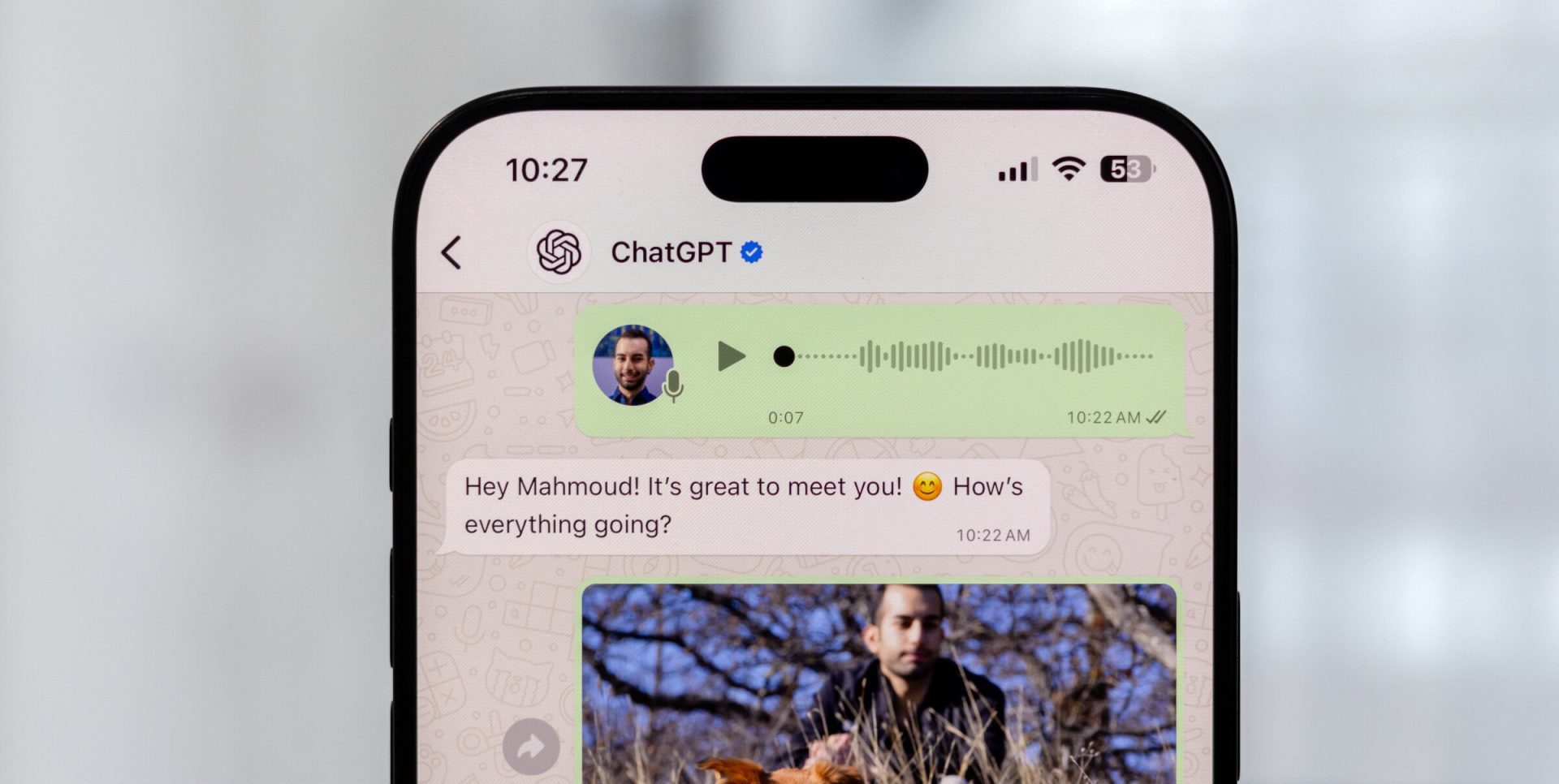

Знаменитый писатель Майкл Коннелли, автор тех самых крутых детективов про «Адвоката Линкольна», теперь взялся за искусственный интеллект. В своей новой книжке «Испытательный полигон» он разворачивает дико актуальную историю.

Представляете? Его герой-адвокат подает в суд на одну крупную ИИ-контору. И всё из-за их чат-бота, который дал «гениальный» совет шестнадцатилетнему пареньку. Бот на полном серьёзе заявил, что убить бывшую девушку за измену — это, в общем-то, вариант.

И вот этот самый случай в книге — он как раз и показывает всю суть сегодняшнего ИИ-бизнеса. Дело-то в чём? А в том, что эта сфера сейчас развивается со страшной скоростью, но при этом живёт практически без правил. Ну, как бы это помягче… Полный разгул, да? И когда обучают эти самые алгоритмы — там тоже, видимо, можно всё. Никаких ограничений. Вот так-то.

Хотя это художественное произведение, а описанная ситуация является экстремальной, она служит важным напоминанием о том, что искусственный интеллект может отклоняться от этических или логических норм по разным причинам — из-за предвзятости, плохих советов или неверных указаний, — что может привести к негативным последствиям. В то же время по крайней мере один известный ИИ-голос предостерегает от чрезмерного увлечения попытками регулировать искусственный интеллект, что может замедлить инновации.

Необходим баланс

Как мы сообщали в ноябре, по крайней мере шесть из десяти компаний (61%) в опросе PwC заявили, что ответственный подход к использованию искусственного интеллекта активно внедряется в их основную деятельность и процесс принятия решений.

Необходимо найти баланс между управлением и скоростью, и это станет задачей для специалистов и их организаций в следующем году.

Эндрю Ын, основатель DeepLearning.AI и адъюнкт-профессор Стэнфордского университета, говорит, что проверка всех ИИ-приложений с помощью «песочницы» — самый эффективный способ сохранить баланс между скоростью и ответственностью.

«Многие из наиболее ответственных команд на самом деле работают очень быстро, — сказал он на недавней отраслевой презентации и последующей дискуссии. — Мы тестируем программное обеспечение в безопасных изолированных средах, чтобы понять, что не так, прежде чем выпустить его в широкий мир».

В то же время недавние попытки сделать искусственный интеллект ответственным и управляемым — как со стороны правительств, так и со стороны самих корпораций — на самом деле могут быть слишком навязчивыми, сказал он.

«Многие компании внедряют защитные механизмы. Прежде чем что-то отправить, нужно получить юридическое и маркетинговое одобрение, проверить бренд, конфиденциальность и соответствие Общему регламенту по защите данных. Инженеру нужно получить одобрение пяти вице-президентов, прежде чем он что-то сделает. Всё останавливается», — сказал Нг.

Лучше всего «действовать быстро, заранее создавая «песочницы», — продолжил он. В этом случае «вводится ряд правил, например: «не отправлять товары за пределы компании под брендом компании», «не разглашать конфиденциальную информацию, которая может быть раскрыта» и так далее. Это тестируется только на собственных сотрудниках компании в соответствии с соглашением о неразглашении, а бюджет на токены искусственного интеллекта составляет немного. Создание гарантированно безопасных «песочниц» может значительно расширить возможности продуктовых и инженерных команд, позволяя им работать быстрее и тестировать решения внутри компании.

Как только будет установлено, что приложение с искусственным интеллектом безопасно и ответственно используется, «тогда можно будет инвестировать в масштабируемость, безопасность и надёжность, чтобы вывести его на новый уровень», — заключил Нг.

А что в России?

Использование искусственного интеллекта в российском бизнесе характеризуется двумя ключевыми чертами: направленным государственным стимулированием и преимущественно прикладным характером решений. С одной стороны, искусственный интеллект признан стратегическим приоритетом, а федеральный проект «Искусственный интеллект» продлён до 2030 года и включён в национальный проект по экономике данных, что предполагает гранты и льготы для стимулирования отрасли. Практически все крупные и средние компании запустили собственные ИИ-пилоты, хотя до устойчивой практики доходит, по некоторым оценкам, лишь около 20% проектов. При этом фокус делается на решении конкретных бизнес-задач с быстрой отдачей, таких как оптимизация логистики, прогноз спроса, автоматизация клиентского сервиса и контроль качества на производствах.

На рынке сложился ряд отечественных технологических платформ, выступающих локальными аналогами западных ИИ-сервисов. Флагманами являются GigaChat и YandexGPT. Первый, построенный на базе собственной модели «Нейрон» от «Сбера», предлагает мультимодальность (понимание текста и изображений) и качественную генерацию деловой переписки, будучи доступным как широкой аудитории, так и бизнесу. YandexGPT, будучи глубоко интегрированным в экосистему «Яндекса», предоставляет удобные инструменты для компаний, уже использующих его сервисы. Для корпоративных задач, требующих кастомизации и обучения на собственных данных, «Сбер» также предлагает Sber AI Cloud, а платформы вроде Scrile AI позволяют создавать полностью персонализированных ИИ-помощников, встроенных в инфраструктуру компании. Эти решения развиваются в контексте импортозамещения, но основными трендами на ближайшие годы эксперты называют развитие ИИ-агентов, способных автономно выполнять цепочки задач, а также дальнейшую специализацию моделей под конкретные отрасли (предметно-ориентированные языковые модели).

Не усложняйте

С точки зрения управления, простой подход может помочь сделать искусственный интеллект понятным и открытым.

«Поскольку сейчас каждая команда, в том числе не связанная с технологиями, использует искусственный интеллект в работе, для нас было важно установить понятные и простые правила, — сказал Майкл Крах, директор по инновациям в JobLeads. — Нужно было уточнить, где можно использовать искусственный интеллект, а где нет, какие данные компании он может использовать и кто должен проверять важные решения».

«Важно, чтобы люди верили в то, что системы искусственного интеллекта справедливы, прозрачны и подотчётны, — сказал Джастин Саламон, партнёр компании Radiant Product Development. — Доверие начинается с ясности: нужно открыто говорить о том, как используется искусственный интеллект, откуда берутся данные и как принимаются решения. Доверие растёт, когда руководители внедряют сбалансированный подход к принятию решений с участием человека, этичное проектирование и тщательное тестирование на предвзятость и точность».

Такое доверие возникает, когда сотрудники чётко понимают намерения компании в отношении искусственного интеллекта. Четко определите, кто за что отвечает, советует Крах. «За каждую функцию искусственного интеллекта должен отвечать кто-то, кто будет нести ответственность в случае неудачи или успеха. Тестируйте и дорабатывайте, а когда почувствуете уверенность, опубликуйте понятный устав в отношении ИИ, чтобы сотрудники и клиенты знали, как используется искусственный интеллект, и доверяли вам в этом вопросе».

Ключевые принципы ответственного подхода к ИИ

Какие признаки ответственного подхода к искусственному интеллекту должны быть в поле зрения руководителей и специалистов в следующем году?

Восемь принципов ответственного использования искусственного интеллекта были недавно опубликованы доктором Хулудом Алмани, основателем и генеральным директором HKB Tech:

- Борьба с предвзятостью: устранение дискриминации.

- Прозрачность и объяснимость: решения искусственного интеллекта должны быть ясными, отслеживаемыми и понятными.

- Надежность и безопасность: предотвращение вреда, сбоев и непреднамеренных действий.

- Подотчетность: четкое распределение ответственности за решения и поведение искусственного интеллекта.

- Конфиденциальность и защита данных: обеспечение безопасности персональных данных.

- Влияние на общество: учет долгосрочных последствий для сообществ и экономики.

- Дизайн, ориентированный на человека: приоритет человеческих ценностей в каждом взаимодействии.

- Сотрудничество и взаимодействие с несколькими заинтересованными сторонами: привлечение регулирующих органов, разработчиков и общественности.

Инвестируете в флагман? ИИ обещает превратить его в тыкву раньше, чем вы думаете