Наверх

НаверхAI браузер Puma на телефоне взлетает так, что я не понял, как он это сделал

Puma работает на iPhone и Android и дает быстрый локальный AI прямо в браузере. Узнай, почему он бесплатный и почему он рвёт ожидания.

Основные идеи

Мнение автора

Запустил Puma Browser на Pixel 9 Pro и, честно, ожидал тормозов, а получил мгновенный отклик локального Qwen 3 1.5b. Офлайн-тест тоже сработал — ИИ отвечает даже без сети, и это дико радует. Единственный напряг — модели весят гигабайты, у меня Qwen занял почти 6 ГБ. Совет простой: если есть свободная память и хочется офлайновой магии без риска для приватности, Puma заходит на ура.

Puma Browser — это бесплатный мобильный веб-браузер с упором на искусственный интеллект. Он позволяет запускать локальный ИИ. Пользователи могут выбрать одну из нескольких языковых моделей, которые отличаются размером и назначением.

Когда я редко обращаюсь к ИИ, то всегда выбираю локальную версию. Обычно это Ollama на настольном компьютере или ноутбуке. Я давно с недоверием отношусь к облачному ИИ по нескольким причинам:

- Он потребляет огромное количество энергии.

- Нет никакой гарантии соблюдения требований конфиденциальности.

- Я не хочу, чтобы мои запросы использовали для обучения LLM.

Только из-за этих трех причин я всегда выбираю локальный ИИ. На компьютере с этим проблем нет, но как быть с мобильными устройствами? Есть ли способ использовать ИИ в браузере без зависимости от сторонних приложений?

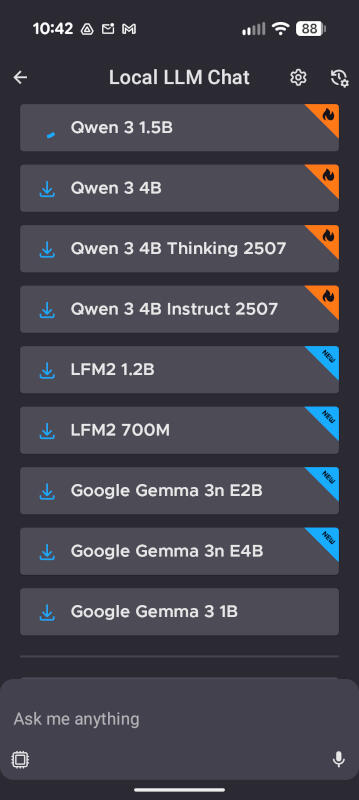

Теперь это возможно с браузером Puma. Он доступен для Android и iOS. Приложение умеет работать с локальными моделями LLM, например Qwen 3 1.5b, Qwen 3 4B, LFM2 1.2, LFM2 700M, Google Gemma 3n E2B и другими.

Я установил браузер Puma на свой Pixel 9 Pro и загрузил Qwen 3 1.5b, чтобы проверить его в деле.

У меня богатый опыт работы с локальным ИИ на разном железе, поэтому я знаю, как сильно он грузит систему. Я думал, что локальный ИИ на смартфоне будет работать ужасно медленно. Также мне известно, сколько памяти занимают эти LLM, поэтому я скачивал их с легким волнением. Я не был уверен, удалятся ли модели вместе с Puma Browser.

Локальный ИИ на Android: плюсы и минусы

Учтите, что локальный ИИ в браузере Puma пока работает в экспериментальном режиме, так что возможны сбои. Загрузка LLM тоже займет время. Обязательно подключитесь к Wi-Fi, иначе процесс затянется и съест мобильный трафик.

Вы можете загрузить любую из доступных моделей LLM для браузера Puma.

Даже через Wi-Fi загрузка Qwen 3 1.5b заняла больше 10 минут.

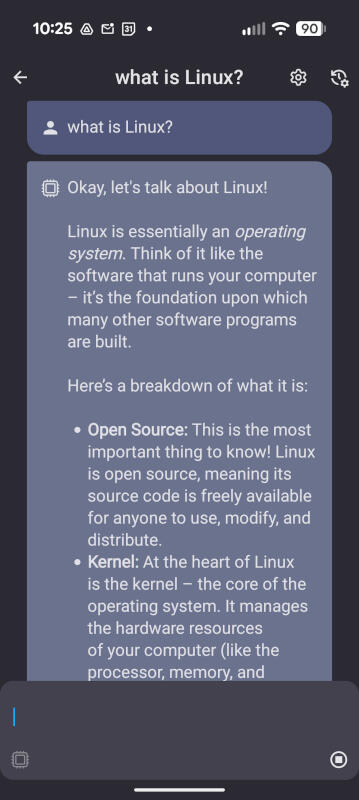

Но как он работает? Я был в шоке. После скачивания LLM я ввел свой обычный тестовый запрос:

- Что такое Linux?

К моему удивлению, браузер Puma ответил мгновенно. Честно говоря, локальная модель на моем Pixel 9 Pro работала так же хорошо, как Ollama на настольном компьютере System76 Thelio с Pop!_OS и на MacBook Pro. Я не мог поверить своим глазам!

Чтобы убедиться в локальной работе Puma, я отключил интернет и Wi-Fi на своем смартфоне, а затем отправил другой запрос. ИИ снова ответил, причем очень быстро. Поверьте, я впечатлен.

Я ничего особенного не ждал от этого браузера и рад, что ошибся. Я готовился к низкой производительности или вообще к нерабочему состоянию локальной LLM, но Puma справился.

Что это значит?

Во-первых, вы можете использовать ИИ на своем телефоне даже без подключения к сети. Кроме того, это не создает лишней нагрузки на и без того перегруженные электросети. На мой взгляд, оба преимущества существенны.

Единственный нюанс — LLM занимают много места на телефоне. Если память устройства регулярно заканчивается и вам приходится удалять фото или видео ради свободного места, локальный ИИ вам не подойдет.

Вам понадобится много памяти на устройстве, особенно если вы планируете переключаться между моделями для разных задач. Я скачивал LLM на компьютер, и они занимали почти 20 ГБ, поэтому будьте внимательны при выборе. Например, вес Qwen 3 1.5b составляет почти 6 ГБ. У вас есть столько свободного места?

Если вы хотите попробовать локальный ИИ на своем смартфоне, браузер Puma — отличный вариант. Он быстрый, простой и позволяет выбирать из нескольких моделей LLM. Попробуйте эту новинку. Возможно, она станет вашим основным инструментом для мобильных ИИ-запросов.

Бонус: Puma также работает как обычный браузер.

Poco официально представила F8 Ultra и F8 Pro — обзор смартфонов