Наверх

НаверхХватит кормить Nvidia: почему ваша компания зря скупает дорогие GPU

Облачные гиганты и производители железа годами вешали нам лапшу на уши. Разбираемся, как сэкономить на ИИ, не теряя в производительности.

Основные идеи

Мнение автора

Эра бездумной скупки GPU заканчивается. Анализ рынка показывает: многие компании переплачивают за мощность, которая им не нужна. Прежде чем утверждать бюджет, стоит провести аудит ИИ-задач. Часто старый A100 или даже CPU справится не хуже, а сэкономленные деньги можно вложить в команду.

Годами нам твердили одно и то же: искусственный интеллект требует огромной вычислительной мощности, а графические процессоры (GPU) — это золотой стандарт для его работы. Компании с готовностью приняли идею, что для обучения и запуска ИИ-моделей необходимы дорогие и самые современные видеокарты. Облачные провайдеры и производители оборудования только подогревали этот ажиотаж, продвигая все новые и более мощные чипы как ключ к конкурентоспособности в гонке ИИ-инноваций.

Но вот удивительная правда: графические процессоры никогда не были так важны для успеха корпоративного ИИ, как нас пытались убедить. Многие задачи, на которые сегодня полагаются компании, такие как системы рекомендаций, предиктивная аналитика и чат-боты, не требуют доступа к самому продвинутому железу. Часто для них с лихвой хватает старых моделей GPU или даже обычных центральных процессоров, которые стоят в разы дешевле.

По мере того как на бизнес давят требования сокращать расходы и повышать эффективность, компании начинают сомневаться в хайпе вокруг GPU. Они ищут более прагматичные решения и меняют свой подход к ИИ-инфраструктуре и инвестициям.

Цены на GPU рухнули, но радоваться рано

Недавние отчеты показывают, что цены на облачные GPU, которые пользуются высоким спросом, резко упали. Например, стоимость спотового экземпляра H100 в облаке AWS в некоторых случаях снизилась на 88%, упав со 105,20 долларов (около 8,5 тыс. руб.) в начале 2024 года до 12,16 долларов (около 1 тыс. руб.) к концу 2025 года. Похожее падение цен наблюдается у всех крупных облачных провайдеров.

На первый взгляд, это хорошая новость. Бизнес экономит деньги, а поставщики облачных услуг корректируют предложение. Однако за этими цифрами скрывается критический сдвиг в принятии бизнес-решений. Снижение цен произошло не из-за перепроизводства, а потому, что приоритеты изменились. Спрос на топовые GPU падает, потому что компании все чаще задаются вопросом: зачем платить за дорогие видеокарты, если более доступные альтернативы предлагают почти идентичные результаты для большинства ИИ-задач?

Не всем нейросетям нужны флагманские видеокарты

Идея о том, что для успеха ИИ нужны только самые большие и лучшие GPU, всегда была ошибочной. Конечно, обучение гигантских моделей вроде GPT-4 или Midjourney требует огромной вычислительной мощности, включая топовые GPU или TPU. Но такие задачи составляют лишь крошечную долю рабочих нагрузок в мире бизнеса. Большинство компаний фокусируются на задачах инференса — то есть, использования уже обученных моделей для реальных приложений: сортировки электронной почты, выдачи рекомендаций по покупкам, обнаружения аномалий и генерации ответов в службе поддержки.

Эти задачи не требуют самых передовых GPU. На самом деле, многие из них прекрасно работают на немного устаревших видеокартах, таких как Nvidia A100 или H100, которые теперь доступны по гораздо более низкой цене. Что еще удивительнее, некоторым компаниям для многих операций, связанных с ИИ, GPU вообще не нужны. Стандартные центральные процессоры без проблем справляются с небольшими и менее сложными моделями. Чат-бот для внутренних HR-запросов или система для прогнозирования энергопотребления не требуют того же железа, что и прорывной исследовательский проект в области ИИ. Многие компании начинают понимать, что погоня за дорогими GPU — это скорее вопрос престижа, а не реальной необходимости.

Когда ИИ стал «новой большой вещью», требования к аппаратному обеспечению взлетели до небес. Компании бросились скупать новейшие GPU, чтобы оставаться конкурентоспособными, а облачные провайдеры были только рады помочь. Проблема в том, что многие из этих решений были продиктованы хайпом и страхом упустить выгоду (FOMO), а не вдумчивым планированием. По словам одного из экспертов отрасли, поведение клиентов при покупке новых GPU часто определяется именно FOMO.

По мере роста экономического давления многие предприятия осознают, что годами переплачивали за свою ИИ-инфраструктуру. ChatGPT создавался на старых графических процессорах Nvidia и работал достаточно хорошо, чтобы установить новые стандарты в индустрии. Если крупные инновации могли быть достигнуты без новейшего оборудования, зачем компаниям настаивать на нем для куда более простых задач? Пришло время пересмотреть выбор железа и определить, соответствует ли он реальным рабочим нагрузкам. И все чаще ответ оказывается отрицательным.

Как реагируют облачные гиганты

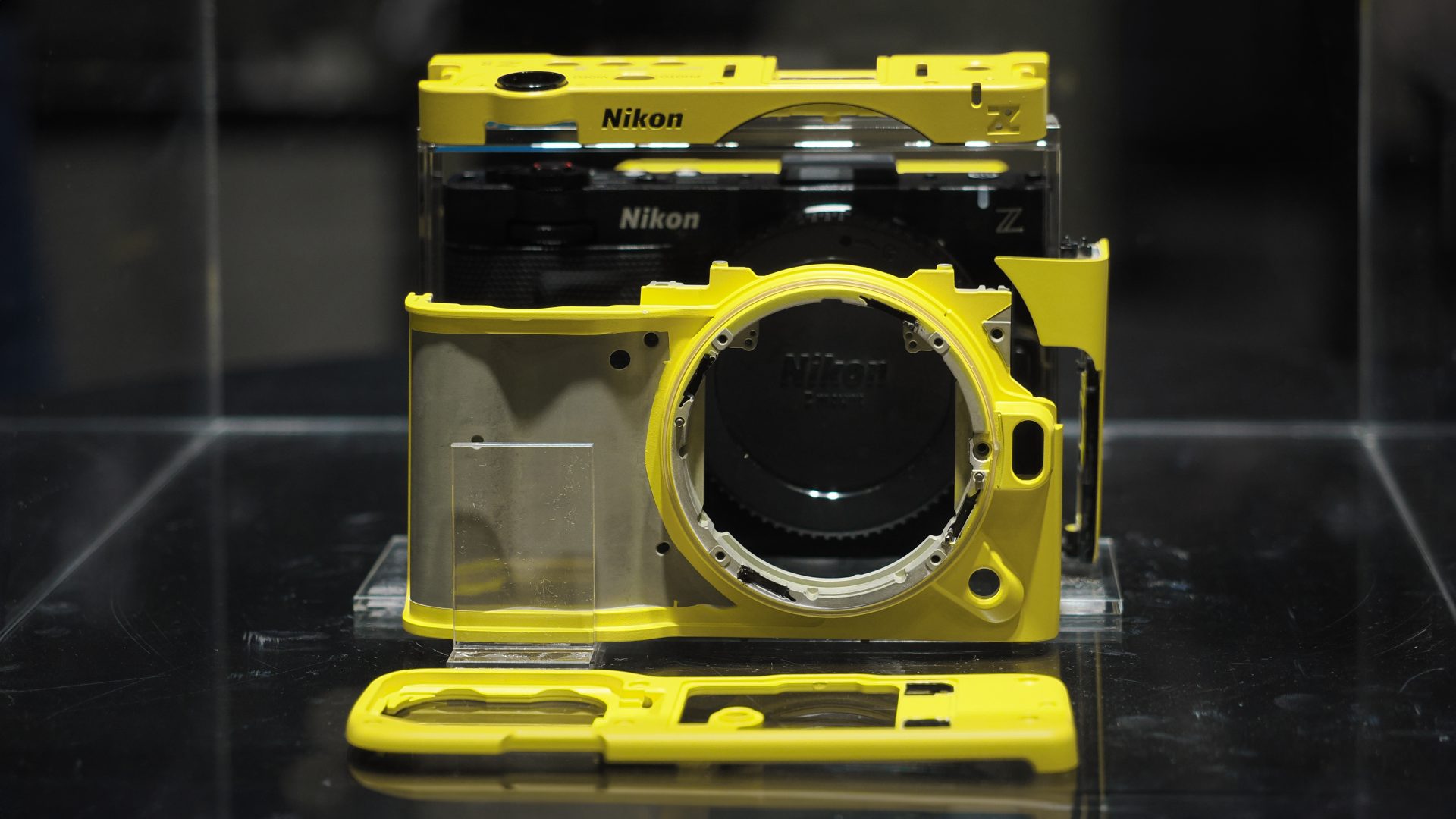

Этот сдвиг заметен и в запасах облачных провайдеров. Топовые GPU, такие как процессоры Nvidia GB200 Blackwell, остаются в дефиците, и в ближайшее время это не изменится. В то же время старые модели, например A100, просто пылятся в дата-центрах, потому что компании отказываются от покупки «следующей большой новинки».

Многие провайдеры, вероятно, переоценили спрос, полагая, что предприятия всегда будут хотеть самые новые и быстрые чипы. В действительности, компании сейчас больше сосредоточены на экономической эффективности, а не на инновациях ради инноваций. Спотовые цены еще больше усугубили эту динамику, поскольку предприятия используют автоматизацию рабочих нагрузок с помощью ИИ, чтобы найти самые дешевые доступные варианты.

Эксперты также объясняют, что предприятия, которые готовы динамически переключать рабочие нагрузки, могут сэкономить до 80% по сравнению с теми, кто привязан к статичным ценовым соглашениям. Такой уровень гибкости был недоступен для многих компаний в прошлом, но с появлением самонастраивающихся систем это становится стандартом.

Дорогие, передовые GPU могут оставаться важным инструментом для инноваций на переднем крае науки, но для большинства компаний путь к успеху с ИИ лежит через старые видеокарты или даже обычные процессоры. Падение цен на облачные GPU показывает, что все больше компаний понимают: для большинства приложений ИИ не требует топового железа. Рынок исправляет сам себя после периода завышенных ожиданий и избыточных трат, делая акцент на окупаемости инвестиций.

Если из всего этого и можно сделать один вывод, то он таков: предприятия должны инвестировать туда, где это действительно важно — в прагматичные решения, которые приносят пользу бизнесу, не разоряя его. Суть ИИ никогда не была в железе. Компании должны сосредоточиться на получении ценных инсайтов, повышении эффективности и улучшении процесса принятия решений. Успех заключается в том, как компании используют ИИ, а не в оборудовании, которое его питает. Для тех, кто надеется преуспеть в будущем, которое определит ИИ, пришло время отказаться от устаревших представлений и перейти к более разумному подходу к инвестициям в инфраструктуру.

Гибридный прорыв: CPU от Intel и GPU RTX от NVIDIA в одном чипе